Elon Musk ha reso disponibile gratuitamente la sua intelligenza artificiale generativa, Grok, per tutti gli utenti di X, sebbene con alcune limitazioni. Lanciata inizialmente a novembre 2023, era prima accessibile solo tramite un abbonamento a pagamento.

Già dall’estate scorsa, Grok è stata al centro di polemiche per la proliferazione di immagini false di personaggi famosi create dagli utenti. Mentre altre AI generative tendono a limitare la creazione di volti noti per tutelare la privacy, prevenire fake news o contenuti illeciti, Grok adotta misure meno rigide.

Come funziona Grok, l’AI gratuita di Elon Musk?

Come molte delle AI più diffuse, Grok funziona principalmente attraverso l’utilizzo di prompt, ovvero istruzioni testuali, ma offre anche numerose altre applicazioni pratiche. Per accedere al servizio è sufficiente cliccare sulla relativa voce nel menu a sinistra quando si utilizza X.com su browser desktop. Si aprirà una finestra laterale che consente di interagire direttamente con l’AI.

Tra gli utilizzi più comuni suggeriti dall’interfaccia ci sono l’aiuto con i compiti scolastici, la ricerca di ricette per la cucina e l’intrattenimento, come raccontare barzellette o aneddoti. Elon Musk ha sottolineato più volte che Grok è progettata per essere “più divertente” e spiritosa rispetto alle alternative offerte da altre aziende.

Deepfake, tutti i rischi di Grok

Una funzione aggiuntiva è la generazione di immagini ultra-realistiche, che ha già favorito la diffusione di contenuti falsi sulla piattaforma. Le immagini create ora includono una piccola filigrana nell’angolo in basso a destra, con il nome dell’AI, sebbene questa possa essere facilmente rimossa.

Da quando Grok è diventata accessibile a tutti, molti utenti hanno condiviso immagini che ritraggono personaggi famosi in situazioni umoristiche o controverse.

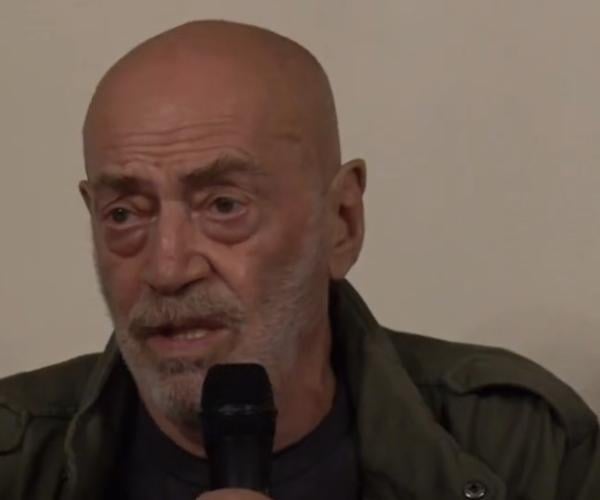

L’assenza di restrizioni rigorose consente la generazione di immagini di elevato realismo. Di recente, Grok ha ampliato il suo repertorio, permettendo di creare immagini che raffigurano figure politiche e celebrità italiane che in precedenza non erano riconosciute dall’AI. Tra gli esempi più discussi ci sono immagini che ritraggono Matteo Salvini, Giorgia Meloni e il sindaco di Milano Beppe Sala.

Grok, il sistema di intelligenza artificiale di xAI (Musk), ora genera immagini anche con i leader politici italiani (fino a qualche tempo fa si limitava a poche figure globali).

— Lorenzo Pregliasco (@lorepregliasco) December 12, 2024

La somiglianza è impressionante: quanto diventerà difficile distinguere vero e falso? pic.twitter.com/ZACkI9ZwgV

Abbiamo già parlato in un precedente articolo di quanto la creazione di immagini mediante l’intelligenza artificiale sia già un’arma potentissima a livello di propaganda politica, sfruttata finora soprattutto dai partiti di estrema destra. Ma non è questa l’unica preoccupazione legata all’utilizzo indiscriminato di questa tecnologia.

Provate ad immaginare i rischi legati all’abuso di questo strumento da parte di cyberbulli che vogliono prendere di mira una persona, umiliandola e ridicolizzandola; o degli estorsori che ricattano le persone chiedendo denaro per non diffondere foto compromettenti. Se prima bastava stare attenti, adesso non sarà più sufficiente, perché una qualsiasi propria foto presa dai social può essere manipolata.

Al momento, fortunatamente, alcune restrizioni tecniche impediscono a Grok di generare contenuti sessualmente espliciti, ma può bastare anche meno per danneggiare la reputazione di una persona o per costringerla a cedere a richieste estorsive.

Con l'#AI prepariamoci a un mondo di fake news e manipolazione. (Immagine generata con Grok) #meloni #renzi pic.twitter.com/0EQ7qm6uvy

— Il lettore incallito (@lettorincallito) December 15, 2024

Responsabilità condivisa contro l’abuso dell’AI

L’utilizzo etico dell’intelligenza artificiale rappresenta una sfida complessa che richiede uno sforzo congiunto da parte di sviluppatori, legislatori e utenti.

Gli sviluppatori, in particolare, hanno il compito cruciale di progettare sistemi tecnologici che integrino barriere tecniche efficaci per limitare la possibilità di abusi. Ad esempio filtri avanzati per il riconoscimento e il blocco di contenuti sensibili o manipolati, oltre a strumenti per identificare eventuali utilizzi illeciti della tecnologia. La responsabilità delle aziende non si limita alla prevenzione: è altrettanto fondamentale promuovere trasparenza e responsabilità, offrendo agli utenti strumenti educativi per comprendere le capacità e i limiti dell’AI.

Parallelamente, i governi devono intervenire con urgenza, adottando normative aggiornate che regolino l’uso delle intelligenze artificiali generative e stabiliscano pene severe per chi utilizza strumenti come i deepfake per scopi illeciti, come estorsione, frode o diffamazione. Questo richiede un approccio legislativo flessibile, in grado di stare al passo con l’evoluzione tecnologica e di prevedere le nuove minacce che potrebbero emergere in futuro.

Anche gli utenti, tuttavia, giocano un ruolo fondamentale. È necessario promuovere una cultura della consapevolezza digitale, dove ciascun individuo sappia riconoscere e gestire i rischi connessi all’AI generativa. Questo include imparare a distinguere contenuti autentici da manipolazioni, nonché adottare comportamenti responsabili nell’utilizzo di queste tecnologie.

Solo attraverso un’azione coordinata tra sviluppatori, istituzioni e società civile sarà possibile ridurre i rischi insiti in una tecnologia che, pur offrendo enormi opportunità, rappresenta anche una delle più grandi sfide etiche del nostro tempo. L’obiettivo comune deve essere quello di sfruttare le potenzialità dell’intelligenza artificiale senza mettere a rischio i diritti, la sicurezza e la dignità delle persone.